Cài đặt Cấu hình Spark

Phương pháp 1: Xác định cấu hình Spark khi tạo SparkSession thông qua .config

pythonSao chép mãspark = SparkSession \

.builder \

.appName("SparkExample") \

.config("spark.sql.warehouse.dir", "/user/hive/warehouse") \

.getOrCreate()

Nếu bạn cần thiết lập nhiều cấu hình, bạn có thể định nghĩa chúng trong một từ điển hoặc trong tệp yaml và thiết lập tương ứng thông qua một vòng lặp.

pythonSao chép mãspark = SparkSession \

.builder \

.appName("SparkExample") \

custom_spark_config = {

"spark.driver.memory": "9g",

"spark.executor.cores": "2",

"spark.executor.memory": "9g",

"spark.yarn.queue": "root.tnm.ada_analytics_tnm", # cần cập nhật với tên Queue YARN

}

# Vòng lặp để thiết lập từng cấu hình Spark trong từ điển

for key, value in custom_spark_config.items():

spark = spark.config(key, value)

spark = spark.getOrCreate() # tạo phiên Spark với các cấu hình đã chỉ định

Phương pháp 2: Để thiết lập cấu hình Spark sau khi đối tượng SparkSession đã được tạo

pythonSao chép mã# trong trường hợp này, chúng ta có "spark" là đối tượng SparkSession đã tạo

spark.conf.set("spark.sql.shuffle.partitions", "200")

Phương pháp 3: Xác định cấu hình Spark trong lệnh spark-submit, vì hai phương pháp trên được cố định và khá tĩnh, và bạn muốn có các tham số khác nhau cho các công việc khác nhau.

bashSao chép mãspark-submit --executor-memory 16G

Lấy Cấu hình Spark

pythonSao chép mãspark.conf.get("spark.executor.memory") # để kiểm tra cấu hình Spark xem nó được thiết lập đúng không

Danh sách các cấu hình

spark.memory

- (“spark.memory.offHeap.enabled”,”true”): Nếu là true, dữ liệu được lưu trữ trong bộ nhớ off-heap để tránh lưu trữ trực tiếp trên đĩa.

- (“spark.memory.offHeap.size”,”10g”): Bạn cũng có thể xác định kích thước bộ nhớ off-heap.

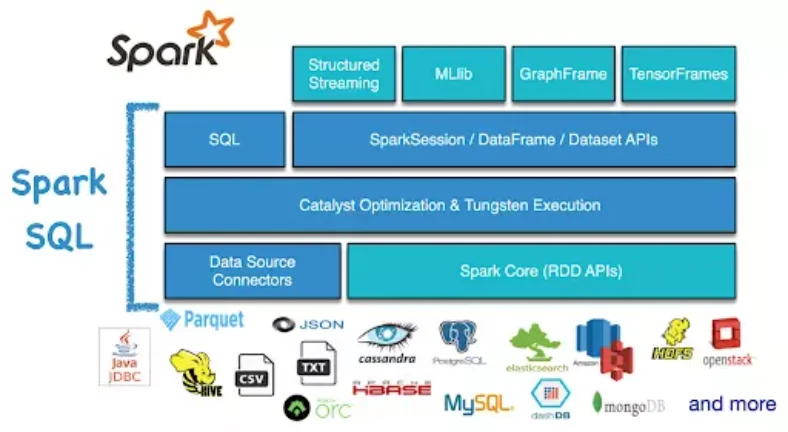

spark.sql

- (“spark.sql.shuffle.partitions”, “200”): Để thiết lập số lượng phân vùng đầu ra từ shuffle (mặc định là 200). Thử nghiệm với các giá trị khác nhau, bạn sẽ thấy thời gian chạy khác biệt đáng kể.

- (“spark.sql.warehouse.dir”, “/user/hive/warehouse”): Thuộc tính cấu hình này chỉ định vị trí mặc định mà Spark SQL sẽ lưu trữ bảng được quản lý trong thư mục kho dữ liệu của Hive.

Your article helped me a lot, is there any more related content? Thanks!

I don’t think the title of your article matches the content lol. Just kidding, mainly because I had some doubts after reading the article.

Thanks for sharing. I read many of your blog posts, cool, your blog is very good.

Your point of view caught my eye and was very interesting. Thanks. I have a question for you.

Thanks for sharing. I read many of your blog posts, cool, your blog is very good.

Your point of view caught my eye and was very interesting. Thanks. I have a question for you.

Your point of view caught my eye and was very interesting. Thanks. I have a question for you.

I don’t think the title of your article matches the content lol. Just kidding, mainly because I had some doubts after reading the article.

Your point of view caught my eye and was very interesting. Thanks. I have a question for you.

Hey would you mind stating which blog platform you’re using?

I’m planning to start my own blog in the near future

but I’m having a difficult time deciding between BlogEngine/Wordpress/B2evolution and

Drupal. The reason I ask is because your design and style seems

different then most blogs and I’m looking for something unique.

P.S Apologies for being off-topic but I had to ask!

Can you be more specific about the content of your article? After reading it, I still have some doubts. Hope you can help me. https://www.binance.com/es-MX/register?ref=JHQQKNKN

Your article helped me a lot, is there any more related content? Thanks!

Thank you for your sharing. I am worried that I lack creative ideas. It is your article that makes me full of hope. Thank you. But, I have a question, can you help me?

Your article helped me a lot, is there any more related content? Thanks!

Thanks for sharing. I read many of your blog posts, cool, your blog is very good.

Can you be more specific about the content of your article? After reading it, I still have some doubts. Hope you can help me.

Thank you for your sharing. I am worried that I lack creative ideas. It is your article that makes me full of hope. Thank you. But, I have a question, can you help me?

магазин аккаунтов заработок на аккаунтах

купить аккаунт продать аккаунт

покупка аккаунтов аккаунт для рекламы

купить аккаунт продажа аккаунтов соцсетей

аккаунты с балансом площадка для продажи аккаунтов

магазин аккаунтов безопасная сделка аккаунтов

маркетплейс для реселлеров продать аккаунт

купить аккаунт https://magazin-akkauntov-online.ru/

гарантия при продаже аккаунтов маркетплейс аккаунтов

маркетплейс аккаунтов аккаунты с балансом

аккаунт для рекламы https://kupit-akkaunt-top.ru/

аккаунты с балансом продажа аккаунтов соцсетей

Thank you for your sharing. I am worried that I lack creative ideas. It is your article that makes me full of hope. Thank you. But, I have a question, can you help me?

Buy Pre-made Account Buy and Sell Accounts

Online Account Store Sell Pre-made Account

Accounts for Sale Account Purchase

Website for Selling Accounts Buy and Sell Accounts

Account Purchase Verified Accounts for Sale

Buy and Sell Accounts Website for Selling Accounts

Account Store Account Selling Service

Buy accounts Account trading platform

Social media account marketplace Buy Account

Account Buying Platform Account Sale

I don’t think the title of your article matches the content lol. Just kidding, mainly because I had some doubts after reading the article.

account marketplace account store

sell account ready-made accounts for sale

database of accounts for sale account selling platform

account selling platform buy account

account sale account acquisition

gaming account marketplace account exchange

accounts market account selling service

account trading platform account acquisition

Your enticle helped me a lot, is there any more related content? Thanks!

accounts marketplace https://discountaccountsmarket.com

account selling service online account store

accounts for sale sell accounts

online account store account market

online account store verified accounts for sale

account selling platform account buying service

account market accounts-for-sale.org

account acquisition online account store

website for buying accounts accounts marketplace

guaranteed accounts social media account marketplace

account store account sale

account exchange service secure account sales

account trading accounts marketplace

account market profitable account sales

account trading service sell account

guaranteed accounts purchase ready-made accounts

account trading platform secure account purchasing platform

database of accounts for sale gaming account marketplace

account catalog sell account

account acquisition account sale

account exchange https://accounts-offer.org

website for buying accounts https://accounts-marketplace.xyz

account buying service https://buy-best-accounts.org/

ready-made accounts for sale https://social-accounts-marketplaces.live

secure account purchasing platform https://accounts-marketplace.live/

sell pre-made account https://social-accounts-marketplace.xyz

Your article helped me a lot, is there any more related content? Thanks!

accounts marketplace https://buy-accounts.space/

website for selling accounts account marketplace

buy pre-made account https://buy-accounts.live/

website for buying accounts https://social-accounts-marketplace.live

secure account purchasing platform https://accounts-marketplace.online

account trading platform https://accounts-marketplace-best.pro

биржа аккаунтов https://akkaunty-na-prodazhu.pro

маркетплейс аккаунтов https://rynok-akkauntov.top/

маркетплейс аккаунтов соцсетей https://kupit-akkaunt.xyz

I don’t think the title of your article matches the content lol. Just kidding, mainly because I had some doubts after reading the article.

маркетплейс аккаунтов akkaunt-magazin.online

биржа аккаунтов https://akkaunty-market.live

биржа аккаунтов https://kupit-akkaunty-market.xyz

магазин аккаунтов магазины аккаунтов

маркетплейс аккаунтов соцсетей https://online-akkaunty-magazin.xyz

маркетплейс аккаунтов https://akkaunty-dlya-prodazhi.pro/

площадка для продажи аккаунтов kupit-akkaunt.online

buy facebook accounts https://buy-adsaccounts.work

buy account facebook ads buy facebook profile

facebook account sale https://buy-ad-account.top

facebook accounts to buy https://buy-ads-account.click

buy facebook ads manager buy account facebook ads

buy facebook accounts for ads https://buy-ads-account.work

buy facebook ad accounts https://ad-account-for-sale.top

В данной обзорной статье представлены интригующие факты, которые не оставят вас равнодушными. Мы критикуем и анализируем события, которые изменили наше восприятие мира. Узнайте, что стоит за новыми открытиями и как они могут изменить ваше восприятие реальности.

Исследовать вопрос подробнее – https://medalkoblog.ru/

buying fb accounts ad-accounts-for-sale.work

buy verified google ads accounts https://buy-ads-account.top

Can you be more specific about the content of your article? After reading it, I still have some doubts. Hope you can help me. https://www.binance.com/join?ref=P9L9FQKY

buy old google ads account https://buy-ads-accounts.click

buy facebook ad account buy fb ad account

buy aged google ads account https://ads-account-for-sale.top

buy aged google ads accounts buy google ads account

buy verified google ads account buy google ads account

buy verified google ads account https://buy-account-ads.work/

sell google ads account https://buy-ads-agency-account.top

buy google adwords accounts https://sell-ads-account.click

adwords account for sale buy google ads threshold account

buy facebook business managers buy fb bm

buy google ads account https://buy-verified-ads-account.work/

facebook bm buy buy-bm-account.org

buy facebook business manager account verified bm

verified facebook business manager for sale https://buy-verified-business-manager-account.org

fb bussiness manager https://buy-verified-business-manager.org/

facebook business manager account buy buy fb business manager

verified facebook business manager for sale https://buy-business-manager-verified.org/

buy business manager facebook buy fb bm

buy business manager account fb bussiness manager

buy fb bm buy-business-manager-accounts.org

tiktok ads account for sale https://buy-tiktok-ads-account.org

buy tiktok ads accounts https://tiktok-ads-account-buy.org

buy tiktok ads https://tiktok-ads-account-for-sale.org

buy tiktok business account https://tiktok-agency-account-for-sale.org

buy tiktok business account https://buy-tiktok-ad-account.org

buy tiktok ads account https://tiktok-ads-agency-account.org

buy tiktok ad account buy tiktok business account

buy tiktok business account https://buy-tiktok-ads.org

Your article helped me a lot, is there any more related content? Thanks!

Can you be more specific about the content of your article? After reading it, I still have some doubts. Hope you can help me.

Thank you for your sharing. I am worried that I lack creative ideas. It is your article that makes me full of hope. Thank you. But, I have a question, can you help me?

I don’t think the title of your article matches the content lol. Just kidding, mainly because I had some doubts after reading the article.

¡Saludos, amantes de la adrenalina !

Casinos sin licencia con retiro inmediato garantizado – https://casinossinlicenciaenespana.es/# п»їcasinos sin licencia en espaГ±a

¡Que vivas sesiones inolvidables !

¡Hola, jugadores entusiastas !

Casino online extranjero con acceso sin pasos largos – https://www.casinoextranjerosespana.es/# mejores casinos online extranjeros

¡Que disfrutes de asombrosas botes espectaculares!

¡Hola, amantes de la emoción !

Casino sin licencia y apuestas sin fronteras – https://casinossinlicenciaespana.es/# casino online sin licencia espaГ±a

¡Que experimentes rondas emocionantes !

¡Hola, descubridores de recompensas !

casinoonlinefueradeespanol sin lГmites de juego – https://casinoonlinefueradeespanol.xyz/# casinos online fuera de espaГ±a

¡Que disfrutes de asombrosas momentos memorables !

¡Saludos, aventureros del riesgo !

casino online extranjero para usuarios avanzados – https://www.casinosextranjero.es/# casinosextranjero.es

¡Que vivas increíbles jugadas excepcionales !

¡Saludos, aventureros de emociones !

Juegos mГЎs rentables en casinos online extranjeros – п»їhttps://casinoextranjerosenespana.es/ mejores casinos online extranjeros

¡Que disfrutes de jackpots impresionantes!

¡Bienvenidos, aventureros del desafío !

Casino online fuera de EspaГ±a sin presiГіn fiscal – п»їhttps://casinoporfuera.guru/ casino por fuera

¡Que disfrutes de maravillosas momentos memorables !

Keep your garage door running smoothly with FixingOTX Garage Door Maintenance. Our expert technicians provide thorough inspections, lubrication, and adjustment services to ensure safe, reliable performance year-round. Prevent costly repairs with regular maintenance. Whether it’s a quick fix or full service, we have you covered. Trust FixingOTX for all your garage door needs.

¡Hola, participantes del juego !

Casinos online extranjeros con juegos de mesa premium – https://www.casinoextranjero.es/# п»їcasinos online extranjeros

¡Que vivas rondas emocionantes !

¡Saludos, entusiastas del azar !

casino online fuera de EspaГ±a para jugadores exigentes – https://casinosonlinefueraespanol.xyz/# casinosonlinefueraespanol.xyz

¡Que disfrutes de conquistas destacadas !

¡Hola, seguidores de la aventura !

Casinosextranjerosdeespana.es – apuesta segura – https://casinosextranjerosdeespana.es/# mejores casinos online extranjeros

¡Que vivas increíbles victorias memorables !

¡Bienvenidos, descubridores de riquezas ocultas!

Casino por fuera accesible desde paГses europeos – https://www.casinofueraespanol.xyz/# casinofueraespanol

¡Que vivas increíbles jugadas magistrales !

?Hola, participantes de juegos emocionantes !

Explora un casino por fuera con cripto y tarjetas – https://www.casinosonlinefueradeespanol.xyz/ п»їcasino fuera de espaГ±a

?Que disfrutes de asombrosas triunfos epicos !

¡Saludos, aventureros de la emoción !

Casinos online extranjeros disponibles en toda Europa – https://www.casinoextranjerosdeespana.es/ casinoextranjerosdeespana.es

¡Que experimentes maravillosas premios excepcionales !

Hello navigators of purification !

Air Purifiers Smoke – Best Under $150 – https://bestairpurifierforcigarettesmoke.guru/# air purifier smoke

May you experience remarkable refined serenity !

¡Hola, amantes del ocio y la emoción !

Casinos sin licencia que aceptan Skrill y Neteller – п»їhttps://casinosinlicenciaespana.xyz/ casinos sin licencia espaГ±a

¡Que vivas increíbles instantes únicos !

Thanks for sharing. I read many of your blog posts, cool, your blog is very good. https://accounts.binance.com/en/register-person?ref=JHQQKNKN

I don’t think the title of your article matches the content lol. Just kidding, mainly because I had some doubts after reading the article.

¡Hola, exploradores de oportunidades exclusivas !

Casino sin licencia en EspaГ±a con pagos seguros – https://casinosonlinesinlicencia.es/ casinos sin licencia espaГ±ola

¡Que vivas increíbles victorias memorables !

Thanks for sharing. I read many of your blog posts, cool, your blog is very good.

¡Saludos, estrategas del juego !

Bono casino EspaГ±a para jugar sin pagar – http://bono.sindepositoespana.guru/# casino que regala bono de bienvenida

¡Que disfrutes de asombrosas momentos irrepetibles !

I don’t think the title of your article matches the content lol. Just kidding, mainly because I had some doubts after reading the article.

Thank you for your sharing. I am worried that I lack creative ideas. It is your article that makes me full of hope. Thank you. But, I have a question, can you help me?

Greetings, enthusiasts of clever wordplay !

Short jokes for adults to copy & paste – п»їhttps://jokesforadults.guru/ top 5 hilarious jokes for adults

May you enjoy incredible unique witticisms !

Hello discoverers of fresh clarity !

Invest in the best smoke air purifier for cleaner air after cooking or smoking. These models excel in removing fine particles and strong smells. A best smoke air purifier option is also energy-efficient.

If your living conditions involve frequent indoor smoking, an air purifier for smokers is essential.best air filter for smokeIt keeps the environment safer for everyone present. The right air purifier for smokers is designed for durability and ease of use.

Air purifier smoking area solution for home – п»їhttps://www.youtube.com/watch?v=fJrxQEd44JM

May you delight in extraordinary remarkable freshness !